Sur des durées très longues, que prendre comme taux d’actualisation ?

L’évaluateur dispose d’un cadre assez solide quand il s’agit de regarder la valeur des entreprises ou des projets d’entreprise. Il dispose de références de marché (taux d’intérêt dit sans risque, rendement moyen des actions sur les marchés financiers, etc.) et d’un modèle plus ou moins éprouvé (le CAPM) qui indique le risque qu’il faut attacher au projet. Le CAPM se garde de mettre « tout le risque » dans le taux d’actualisation ; il y intègre uniquement la contribution nette du projet en question au risque d’ensemble du marché, ce qu’on appelle le « risque systématique » ou « risque non diversifiable ».

L’affaire est moins simple lorsqu’il s’agit de projets à très long terme ou de projets qui ont une dimension macroéconomique : il n’y a pas de marchés sur des créances à très long terme (au-delà d’une maturité de 30 ans, il n’y a guère de titres financiers échangés[1]), le marché des actions est une référence trop étroite pour la mesure du risque économique. On quitte le domaine du risque mesurable par des lois de probabilité classique pour tomber dans ce qu’on appelle l’incertain. De quoi demain sera-t-il fait ? Qu’on songe aux projets de lutte contre le réchauffement climatique, ou, plus modestes dans leur enjeu, aux projets d’infrastructure routière ou ferroviaire. Enfin, l’accumulation de tels projets n’est plus neutre sur le risque global du marché[2].

S’ajoute une dernière difficulté, liée en partie aux politiques monétaires conduites à peu près partout dans le monde : est-ce que le taux de 0,8% qui ressort des emprunts souverains français donne vraiment la bonne mesure du taux sans risque ?

Tout cela n’est pas indifférent, quand on sait le côté diabolique de la capitalisation : vous faites un projet de tunnel sous les Alpes qui coûte un milliard d’euro pendant 30 ans, mais qui rapporte à partir de la 31ème année un milliard par an jusqu’à la nuit des temps. Un tel projet vaut 5 Md€ environ si le taux (réel) est de 2 % ; en coûte 10 Md€ à 4 %.

L’approche des économistes

La réflexion des économistes remonte très en amont du calcul financier habituel. Elle a été initiée par Frank Ramsey, un philosophe, mathématicien et élève de Keynes en économie, qui aurait peut-être eu l’influence de ce dernier s’il n’était mort prématurément. Une approche complétée par, entre autres noms, John von Neumann, Maurice Allais, Leonard Savage ou Robert Solow. L’angle retenu est résolument normatif : quels sont le gain et le coût du projet du point de vue de la population, ou d’un agent unique qui la représente et qui maximiserait sa satisfaction de façon intertemporelle[3] ?

1- Le point de départ est de bien comprendre le lien entre le taux de croissance de l’économie et le taux d’intérêt. Si l’on veut par exemple investir dans des projets de décarbonisation – dont l’effet se fera sentir à l’échelle de décennies ou de siècles –, le coût et l’utilité pour la population dépendront de son niveau de richesse. Il aurait été absurde de demander à nos arrière-grands parents d’éteindre leur lampe à pétrole au prétexte de leurs émissions de carbone, alors qu’ils étaient considérablement moins riches que nous le sommes. Il est peut-être tout autant absurde de demander que tout l’effort de décarbonisation soit demandé à la génération présente si jamais celles qui suivront sont considérablement plus riches que la nôtre.

L’équité entre générations n’est donc pas l’égalité simple, à savoir un gain identique en montant quel que soit le moment de naissance. Elle n’est pas non plus l’égoïsme intégral, à la Groucho Marx qui disait : « Mais qu’ont fait les générations futures pour nous ? ». Mise fictivement devant le choix du moment de l’histoire où elle veut venir au monde, toute génération aura besoin d’en connaître le niveau de richesse pour juger du poids relatif du gain ou du coût consenti.

Avec cette approche, le bon taux d’actualisation serait simplement le taux de croissance anticipé sur le long terme, soit par exemple 1 ou 2 % (réels).

2- Les économistes introduisent depuis von Neumann une notion d’utilité espérée qui pondère dans le temps le gain obtenu. En gros, un euro de gain net me sera plus « utile » si j’ai un patrimoine de 1 que si j’ai un patrimoine de 50. On introduit alors une notion d’élasticité du gain selon le niveau de richesse, qu’on va appeler gamma. Un poids plus important sera donné à la génération présente (donc un taux plus élevé) si l’élasticité est forte. Comme le dit excellement Christian Gollier[4] :

« Si on dispose d’un euro supplémentaire, autant le dépenser là où son effet sur l’utilité est le plus élevé, c’est-à-dire là où nous sommes le moins riche. […] Plus gamma est élevé, plus il est difficile de demander aux ménages de faire des efforts pour améliorer un futur par ailleurs de toute façon plus confortable que le présent. […] L’offre de crédit se réduira et le taux d’intérêt d’équilibre sera augmenté. »

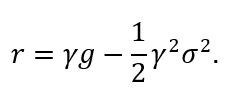

On teste empiriquement le niveau de ce gamma. Le problème est qu’il varie beaucoup, entre 1 et 3. Le rapport Stern sur le réchauffement climatique retient un gamma de 1 ; les deux rapports importants qui ont été publiés récemment sur le sujet du taux d’actualisation pour les grands projets publics (le rapport Lebègue de 2004 et le rapport Gollier de 2011) retiennent un gamma de 2. Toujours est-il qu’on en arrive à une formule célèbre qui veut que le bon taux d’actualisation soit :

![]()

où g est le taux de croissance anticipé de l’économie.

Si g est égal à 1 % (un taux pas très éloigné de la croissance séculaire par tête depuis deux siècles), et gamma égal à 2, cela donne un taux d’actualisation de 2 %.

Ceci paraît peu élevé, mais il faut voir, pour retrouver les réflexes du financier de base, qu’il conviendrait d’y ajouter l’inflation anticipée ; et également l’effet du levier d’endettement[5], soit environ 2X, ce qui donne un taux d’actualisation de 4% en termes réels et de 8% si on y met une inflation à 2 %.

3- Troisième étape, il est coutumier de considérer non simplement le taux de croissance de l’économie, mais le risque attaché à ce taux de croissance. S’il y a beaucoup de volatilité dans la croissance, il est raisonnable de la prendre en compte. Appelons cela une épargne de précaution ou, plus pompeusement, le principe de précaution, qui oblige à diminuer le taux d’actualisation.

Le calcul théorique montre que le facteur de décote lié à ce risque non diversifiable dépend du gamma précédent ainsi que de la volatilité de la croissance, de sorte que le taux ressort à :

Ce troisième effet joue faiblement : si gamma égale 2 et que l’écart-type du taux de croissance est de 4 %, il faut décoter le taux précédent de 0,2 %, la belle affaire, même si, capitalisée sur un siècle, cette différence peut devenir significative.

4- Un débat oppose les experts sur un dernier point, l’opportunité d’introduire une prime de risque, un peu à l’égal de celle qui figure dans le CAPM. Le rapport Lebègue s’y opposait, arguant que les différents projets se mutualisent à l’échelle macroéconomique à travers le temps. Christian Gollier milite pour qu’on le prenne en compte, en utilisant une version plus générale du CAPM, une sorte de bêta macroéconomique[6]. Là encore, l’effet est minime et compense en grande partie celui de la volatilité du taux de croissance.

Où cela nous conduit-il ?

Ces travaux ont eu la conséquence pratique de pousser les autorités publiques à baisser fortement leurs taux d’actualisation dans l’évaluation de leurs projets. De façon surprenante, le Commissariat au plan d’autrefois en France, dans la préparation de son 9ème Plan en 1985, retenait un taux d’actualisation (réel) très élevé : 6 %, relevé à 8 %. L’idée était très « néo-libérale », ce qui surprend sachant l’époque politique : on ne voulait pas, par des taux trop bas, que l’État évince l’investissement privé en pompant toute l’épargne du pays pour ses projets propres.

Ce taux est apparu progressivement trop élevé et a soulevé les critiques des élus locaux, qui militaient – rien d’étonnant – pour un usage moins malthusien des fonds publics. D’où en 2004 la mission conduite par Daniel Lebègue qui, avec rigueur, préconisa de ramener le taux de 8 à 4 % avec une décroissance avec le temps jusqu’à un taux de 2 %. En pratique, les pouvoirs publics retiennent aujourd’hui un taux sans risque de 1,5 % et une « prime de risque » de 3 %, soit 4,5 % au total, un niveau contesté par le rapport Gollier. Les États-Unis restent à 7 %, la Banque mondiale à 8 % et le Royaume-Uni à 3,5 % en dessous de 30 ans et 1% au-delà. Le fameux rapport Stern retient un taux (en moyenne) de 1,4 % qui a soulevé des polémiques, mais qui reste dans le champ exploré par ce rapide papier.

Et quid pour la finance d’entreprise ? Deux choses. D’abord, il y a peu de raison de perdre le sommeil : les taux d’actualisation bien fondés théoriquement restent dans la norme utilisée habituellement, levier et inflation compris, pour le calcul financier. Ensuite, il est important pour chacun de nous, au moins une fois dans sa vie, de soulever le capot et de voir quels sont les fondements de la formule universellement utilisée depuis Irving Fisher pour les évaluations de projet et d’entreprise, à savoir la somme actualisée des flux nets opérationnels.

[1] Dans un papier de 2014, Giglio, Maggiori et Stroebel (« Discounting the very distant future »), dont un résumé figure sur Vox-EU, utilisent les contrats de location / propriété immobilière en Grande-Bretagne, qui sont de type leasehold ou freehold. Les contrats leasehold sont des sortes de baux emphytéotiques d’une durée de 99 à 999 ans, tandis que les contrats freehold sont des baux à perpétuité, assimilables à une propriété pleine et entière. Les contrats leasehold décotent par rapport aux freehold, d’autant plus qu’on se rapproche de leur terme. On en tire un taux d’actualisation. Pour anticiper sur la suite, ce taux (réel) s’établit à 2,6%.

[2] Si l’économie ne fait qu’investir dans des projets dont le bêta est égal à 1,5, le risque de marché s’élève à la longue, ce qui fait que les bêtas de tels projets redescendent vers 1. Le risque financier non diversifiable est en effet une corrélation et non une volatilité.

[3] Que ceux qui s’insurgeraient contre une approche aussi normative et utilitariste de la décision prennent conscience que sans elle on ne peut construire par exemple la notion de valeur actuelle nette, pourtant à la base de la finance.

[4] Gollier Christian, 2005, « Quel taux d’actualisation pour quel avenir ? », Revue française d’économie, vol. 19, n°4, pp. 59-81.

[5] Les comptes de patrimoine de l’INSEE de 2016 indiquent une dette agrégée pour l’économie nationale de 6,6 Tr€ et des fonds propres agrégés de 2,9 Tr€, soit un levier de 2,3X.

[6] Ce modèle plus général, dit CCAPM (consumption-based capital asset pricing model) depuis l’économiste Robert Lucas, ne prend pas comme référence le rendement du marché boursier mais en quelque sorte le « rendement » de la consommation du pays, i.e. son taux de croissance. Cela conduit à rajouter une prime de risque égale à

![]() Avec un bêta de 1,2, cela aboutit à une prime de risque d’environ 0,4 % qui compense le risque sur le taux de croissance de l’économie.

Avec un bêta de 1,2, cela aboutit à une prime de risque d’environ 0,4 % qui compense le risque sur le taux de croissance de l’économie.

Cet article a été publié dans la lettre Vernimmen n° 159. Il est repris avec due autorisation.